Llama 3 és l'últim model de gran llenguatge de Meta. Podeu utilitzar-lo per a diversos propòsits, com ara resoldre les vostres consultes, obtenir ajuda amb els deures i els projectes de l'escola, etc. La implementació local de Llama 3 a la vostra màquina Windows 11 us ajudarà a utilitzar-lo en qualsevol moment, fins i tot sense tenir accés a Internet. Aquest article us mostra com instal·lar Llama 3 en un PC amb Windows 11 .

Com instal·lar Llama 3 en un PC amb Windows 11

La instal·lació de Llama 3 en un ordinador amb Windows 11 mitjançant Python requereix habilitats i coneixements tècnics. Tanmateix, alguns mètodes alternatius us permeten desplegar localment Llama 3 a la vostra màquina Windows 11. Us mostraré aquests mètodes.

Per instal·lar Llama 3 al vostre PC amb Windows 11, heu d'executar algunes ordres al símbol del sistema. Tanmateix, això només us permetrà utilitzar la seva versió de línia d'ordres. Heu de fer més passos si voleu utilitzar la seva interfície d'usuari web. Us mostraré aquests dos mètodes.

Desplegueu Llama 3 a Windows 11 PC mitjançant CMD

Per implementar Llama 3 al vostre PC amb Windows 11, heu d'instal·lar Ollama a la vostra màquina Windows. Els passos per al mateix són els següents:

- Visita Lloc web oficial d'Ollama .

- Feu clic a Descarregar botó i després seleccioneu Windows .

- Ara, feu clic a Descarrega per a Windows botó per desar el fitxer exe al vostre PC.

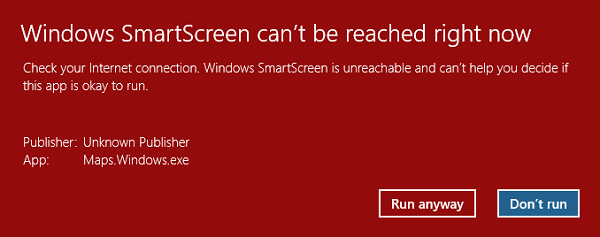

- Executeu el fitxer exe per instal·lar Ollama a la vostra màquina.

Un cop instal·lat l'Ollama al vostre dispositiu, reinicieu l'ordinador. Hauria de funcionar en segon pla. Ho podeu veure a la safata del sistema. Ara, feu clic a l'opció Models del lloc web d'Ollama. Veureu els seus diferents models.

La Llama 3.1 està disponible en els tres paràmetres següents:

les tecles de fletxa i wasd van canviar de Windows 10

- 8B

- 70B

- 405B

L'últim és el paràmetre més gran i, òbviament, no es pot executar en un ordinador de gamma baixa. La Llama 3.2 té els dos paràmetres següents:

- 1B

- 3B

Feu clic a la versió de Llama que voleu instal·lar al vostre PC. Per exemple, si voleu instal·lar Llama 3.2, feu clic a Llama 3.2. Al menú desplegable, podeu seleccionar el paràmetre que voleu instal·lar. Després d'això, copieu l'ordre que hi ha al costat i enganxeu-la a l'indicador d'ordres.

Per a la vostra comoditat, he escrit les dues ordres per al model Llama 3.2. Per instal·lar el model Llama 3.2 3B, executeu l'ordre següent:

el clic esquerre del ratolí no funciona

ollama run llama3.2:3b

Per instal·lar el model Llama 3.2 1B, utilitzeu l'ordre següent:

ollama run llama3.2:1b

Obriu el símbol del sistema, escriviu qualsevol de les ordres esmentades anteriorment (segons els vostres requisits) i premeu Entra . Es necessitarà una mica de temps per descarregar els fitxers necessaris. El temps de descàrrega també dependrà de la velocitat de connexió a Internet. Després de la finalització, veureu el èxit missatge al símbol del sistema.

Ara, escriviu el vostre missatge per utilitzar el model Llama 3.2. Si voleu instal·lar el model Llama 3.1, utilitzeu les ordres disponibles al lloc web d'Ollama.

La propera vegada que inicieu l'indicador d'ordres, utilitzeu la mateixa ordre per executar Llama 3.1 o 3.2 al vostre PC.

La instal·lació de Llama 3 mitjançant CMD té un inconvenient. No desa el vostre historial de xat. Tanmateix, si el desplegueu a l'amfitrió local, el vostre historial de xat es desarà i obtindreu una interfície d'usuari millor. El següent mètode mostra com fer-ho.

Deploy Truca 3 Web UI on Windows 11

L'ús de Llama 3 en un navegador web proporciona una millor interfície d'usuari i també desa l'historial de xat en comparació amb el seu ús a la finestra CMD. Us mostraré com implementar Llama 3 al vostre navegador web.

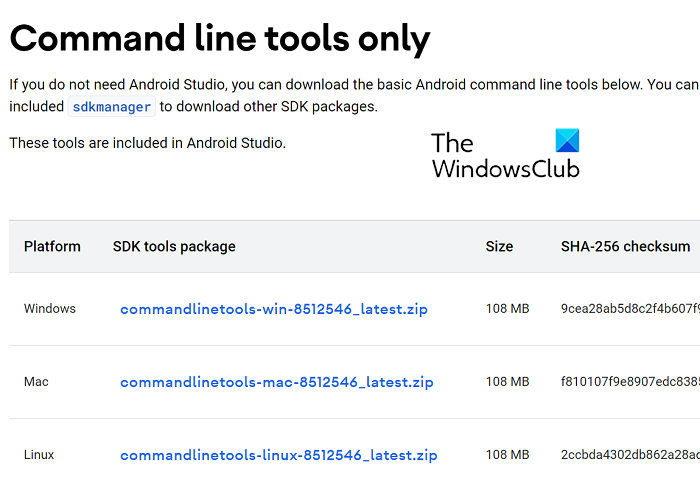

Per utilitzar Llama 3 al vostre navegador web, heu d'instal·lar Llama 3 a través d'Ollama i Docker al vostre sistema. Si encara no heu instal·lat Llama 3, instal·leu-lo amb Ollama (com s'ha explicat anteriorment). Ara, descarregueu i instal·leu Docker des del seu lloc web oficial .

Després d'instal·lar Docker, inicieu-lo i registreu-vos per crear un compte. Docker no s'executarà fins que no us registreu. Després d'haver registrat, inicieu la sessió al vostre compte a l'aplicació Docker. Minimitzar Docker a la safata del sistema. Les aplicacions Docker i Ollama haurien d'executar-se en segon pla. En cas contrari, no podeu utilitzar Llama 3 al vostre navegador web.

pantalla de Windows cap per avall

Ara, obriu el símbol del sistema, copieu l'ordre següent i enganxeu-lo al símbol del sistema:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

L'ordre anterior trigarà un temps a descarregar els recursos necessaris. Per tant, tingueu una mica de paciència. Després de completar l'ordre, obriu Docker i seleccioneu Contenidors secció des del costat esquerre. Veureu que es crea un contenidor automàticament amb el port 3000:8080.

Feu clic al port 3000:8080. Això obrirà una pestanya nova al vostre navegador web predeterminat. Ara, registreu-vos i inicieu la sessió per utilitzar Llama 3 al vostre navegador web. Si veieu la barra d'adreces, ho veureu host local: 3000 allà, el que significa que Llama 3 està allotjat localment al vostre ordinador. Podeu utilitzar-lo sense connexió a Internet.

Seleccioneu el vostre model de xat Llama al menú desplegable. Si voleu afegir més models de xat de Llama 3, heu d'instal·lar-lo mitjançant Ollama mitjançant les ordres necessàries. Després d'això, el model estarà disponible automàticament al vostre navegador web.

Tot el vostre historial de xat es desarà i es podrà accedir al costat esquerre. Quan vulgueu sortir, tanqueu la sessió al vostre navegador web. Després d'això, obriu l'aplicació Docker i feu clic a Atureu-vos botó per aturar Docker. Ara podeu tancar Docker.

Quan vulgueu utilitzar Llama 3 al vostre navegador web la propera vegada, inicieu Ollama i Docker, espereu uns minuts i feu clic al port del contenidor Docker per obrir el servidor localhost al vostre navegador web. Ara, inicieu la sessió al vostre compte i comenceu a utilitzar Llama 3.

Espero que això ajudi.

Es pot executar Llama 3 a Windows?

Depenent de la configuració del maquinari del vostre ordinador, podeu executar Llama 3 al vostre sistema. El seu model 1B és el més lleuger. Podeu instal·lar-lo i executar-lo al vostre sistema mitjançant l'indicador d'ordres.

Windows 10 calibra la bateria

Quanta memòria RAM necessito per al Llama 3?

El model més lleuger de Llama 3 és Llama 3.2 1B. El vostre sistema hauria de tenir 16 GB de RAM per executar el model Llama 3.2 1B. A més d'això, el vostre sistema també hauria de tenir una GPU resistent. Els models superiors de Llama 3 requereixen més recursos del sistema.

Llegeix a continuació : Com utilitzar Leonardo Phoenix AI .

![Kodi no s'instal·larà ni obrirà a l'ordinador [Corregit]](https://prankmike.com/img/kodi/26/kodi-won-rsquo-t-install-or-open-on-pc-fixed-1.jpg)